吸引抓取解释了对新站点或现存站点如何通过构建正确的技术基础和结构,来帮助Google找到页面以及适当的索引全部页面。搜索引擎都通过蜘蛛程序来搜索网络、收集网页、分配唯一标识、扫描文本并提交给索引程序。在扫描时,蜘蛛程序会吧抓取的网页中指向其他网页的超级链接提取出来,并依次抓取这些被指向的网页。

吸引抓取解释了对新站点或现存站点如何通过构建正确的技术基础和结构,来帮助Google找到页面以及适当的索引全部页面。搜索引擎都通过蜘蛛程序来搜索网络、收集网页、分配唯一标识、扫描文本并提交给索引程序。在扫描时,蜘蛛程序会吧抓取的网页中指向其他网页的超级链接提取出来,并依次抓取这些被指向的网页。

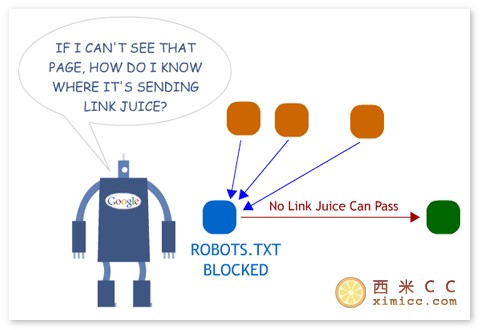

Google如何找到你的网页。在吸引抓取中,你的首要步骤就是要学习Google的爬虫GoogleBot实际上是如何工作的,还有如何使用站点地图和robots.txt来初始化、控制和管理站点上的抓取行为。阻止Google抓取某些特定页面的最佳方法是使用robots.txt文件。它就是一个简单的ASCIl文本文件,放在站点的根目录下面。例如,如果你的域名http://xxxx.cn的话,那么该文件应该被放置在http://xxxx.cn/robots.txt 。你可以通过robots.txt来阻止Google索引图片、运行PERL脚本(例如,需要客户填写的表恪)或者访问带有版权的页面。 robots.txt文件的每块的第一行是蜘蛛的名称,接下来是不允许防问的目录或文件的列表,块与块之间用空行分隔。文件名的格式还支持通配符,例如用“#”和“?”来代表任意数字或字母。

建立新站点包含了关于新站长要如何去托管站点、在哪里托管以及如何选择域名等至关重要的信息。管理现存站点解释了如何将站点迁移到新托管商或者新域名上,而不会对站点产生负面冲击。

站点结构和导航则的关心如何通过改进站点结构,来获得正确的站点深度和宽度,最终获得有效抓取。它包括优化目录结构、文件名和文件开展等等。网站结构分为逻辑结构及物理结构。对SEO来说,西米CC觉得更重要的是由链接形成的逻辑结构,也就是由网页内部链接所形成的逻辑的或链接的网络图。

那么,搜索引擎喜欢什么样的网站逻辑结构呢?是树状结构,因为树状结构符合人们对知识和信息的归类习惯,用户体验更好。